在前面的文中我们分别搭建了单机和集群的Hadoop环境,今天我们将实践使用Eclispe开发工具安装

hadoop的开发插件,并且使用hadoop插件连接Hadoop远程集群,文中有什么不对的地方,请大家指出来

共同学习。

一、环境准备

1.Eclipse Java EE IDE for Web Developers- Oxygen.2 Release (4.7.2)

2.Eclipse的Hadoop插件hadoop-eclipse-plugin-2.6.0.jar

3.Hadoop集群环境

4.deepin15.5稳定版linux系统

注:以上都是本次实践的版本,大家可以选择适合自己的版本

二、安装Eclispe的Hadoop开发插件

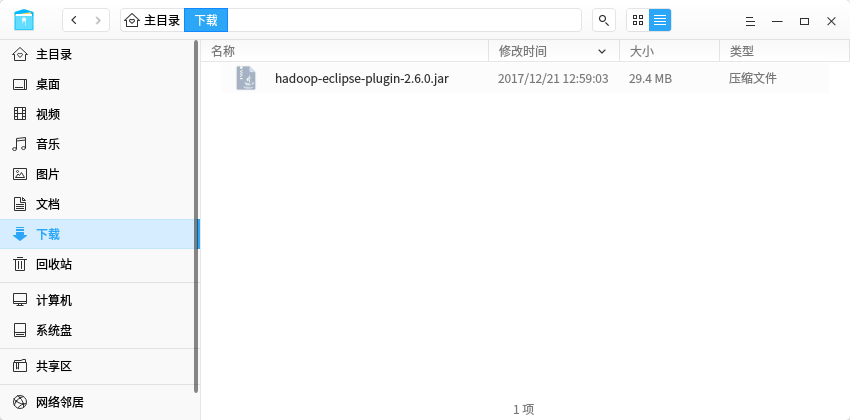

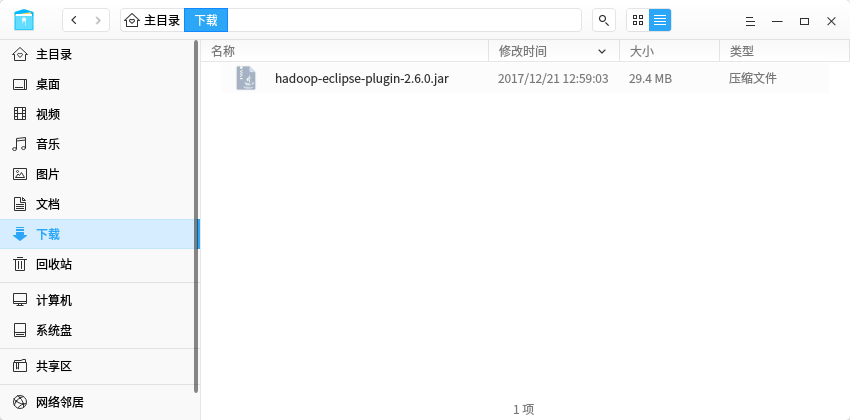

1.下载Eclipse的Hadoop插件hadoop-eclipse-plugin-2.6.0.jar,下载地址:

https://github.com/winghc/hadoop2x-eclipse-plugin

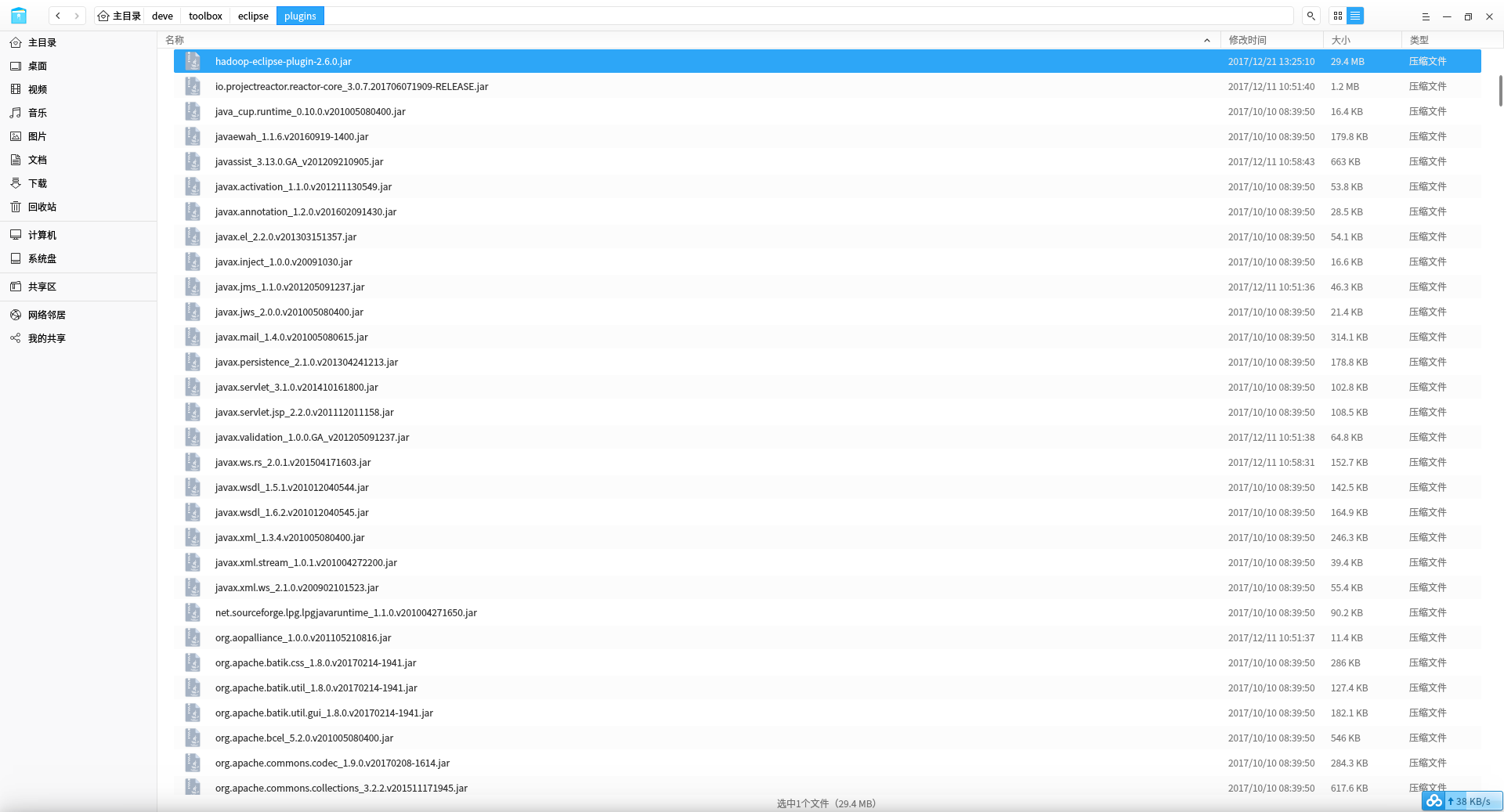

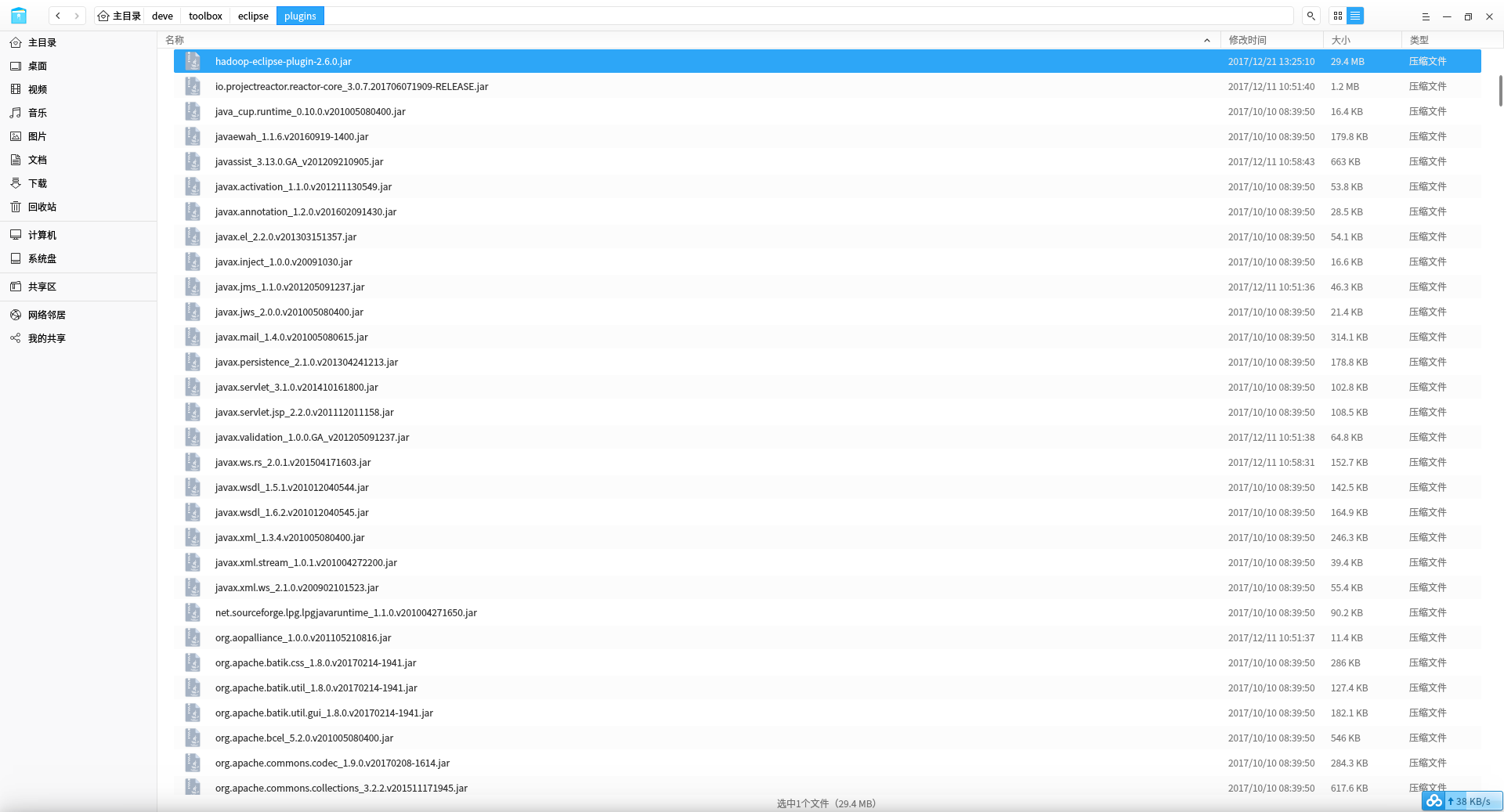

2.将插件复制到eclipse安装目录下的plugins目录

3.启动或者重启Eclispe开发工具

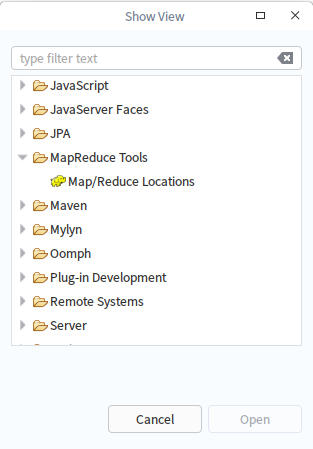

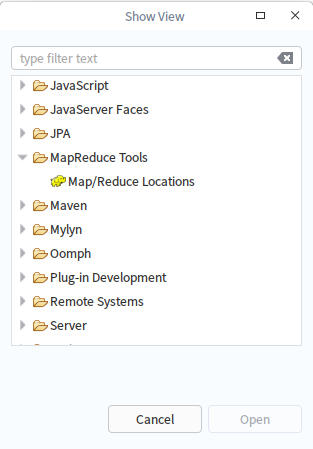

4.打开eclipse的show View窗口,看到了我们安装的Hadoop的插件

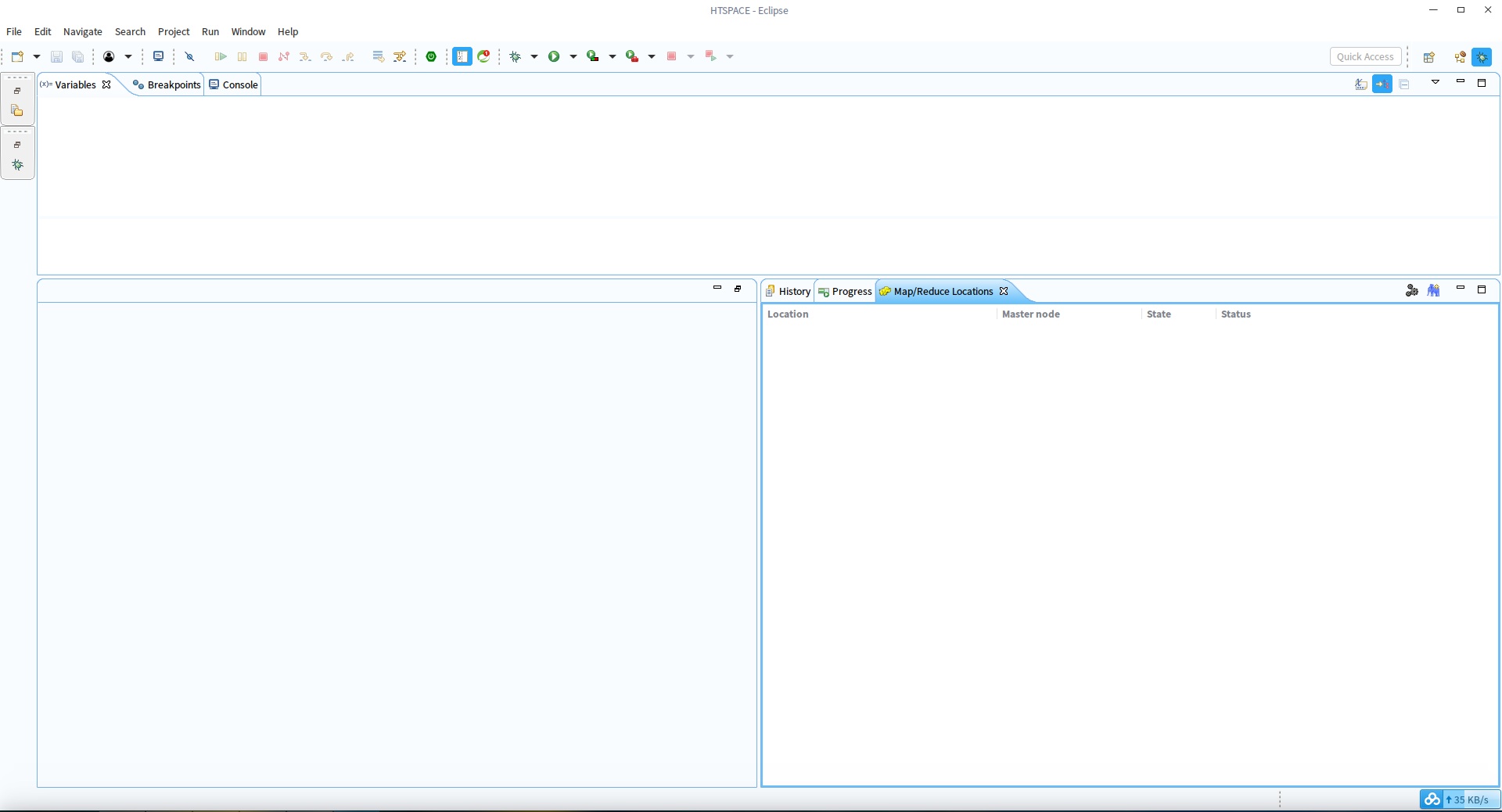

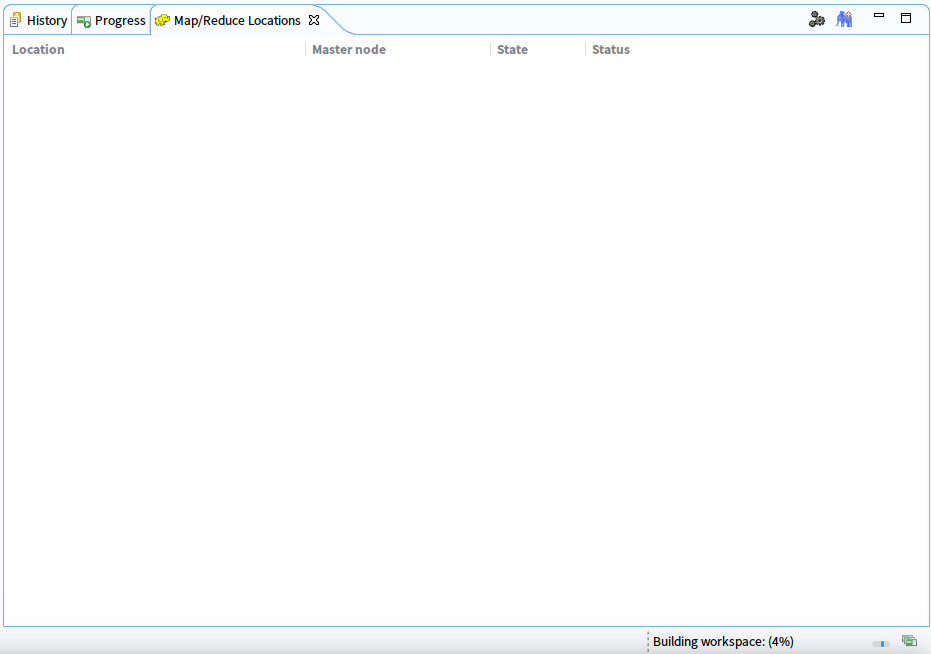

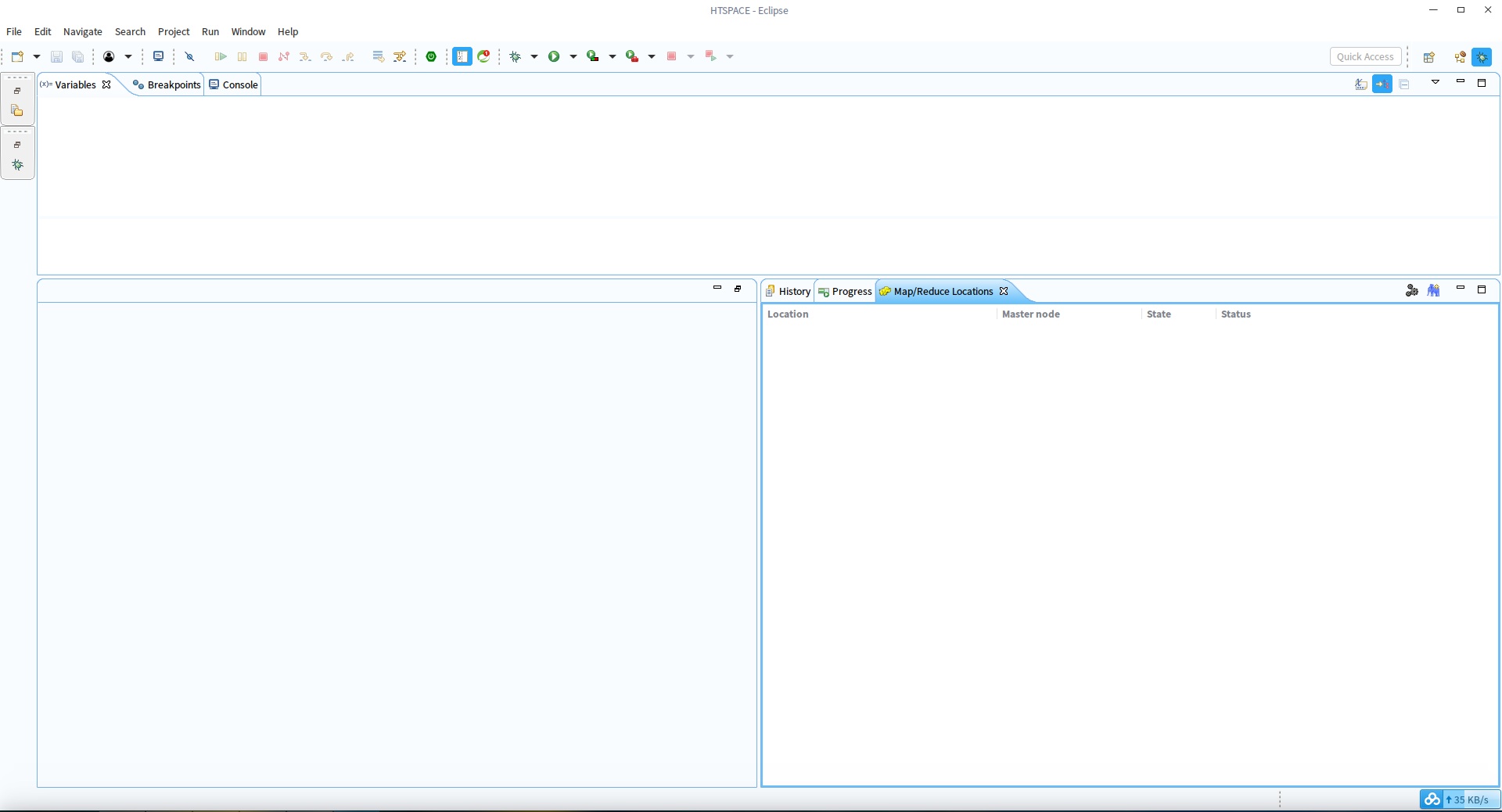

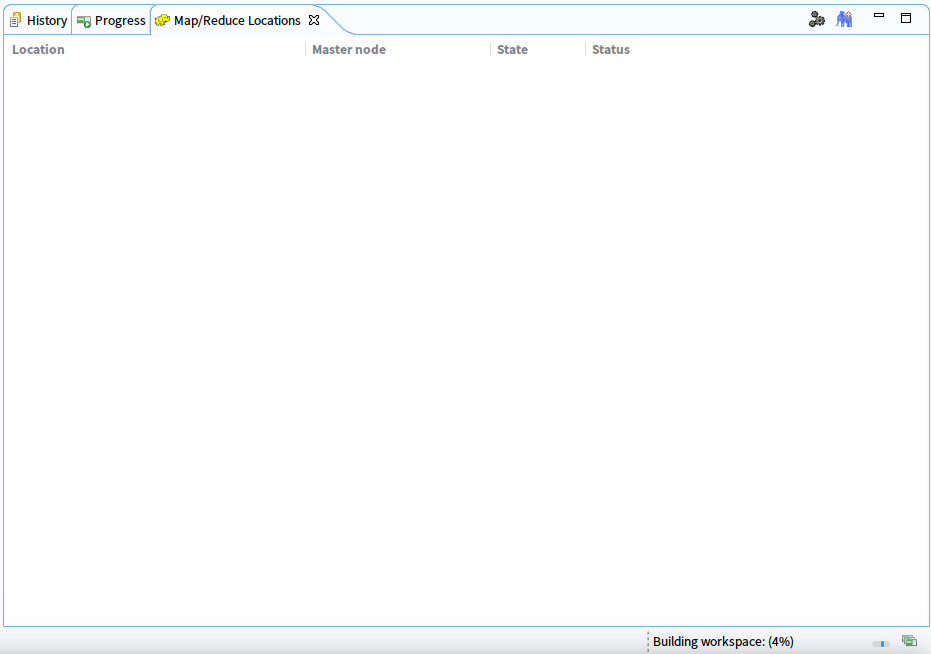

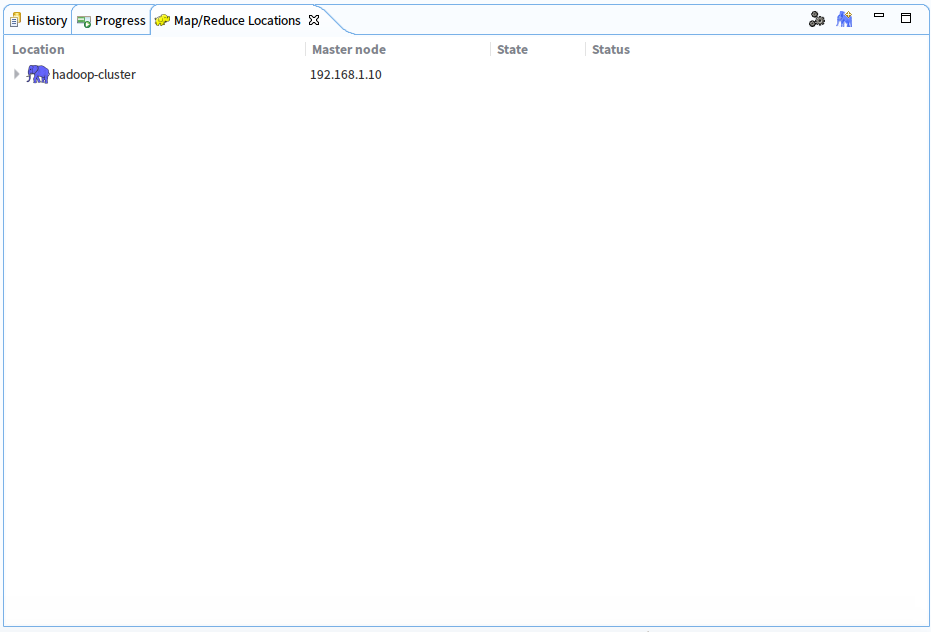

5.点击Map/Reduce Locations打开视图

出现的是hadoop的Map/Reduce开发相关的视图,在视图区域右上方有蓝色小象的添加按钮,此时插

件工作配置完成

三、启动Hadoop集群环境

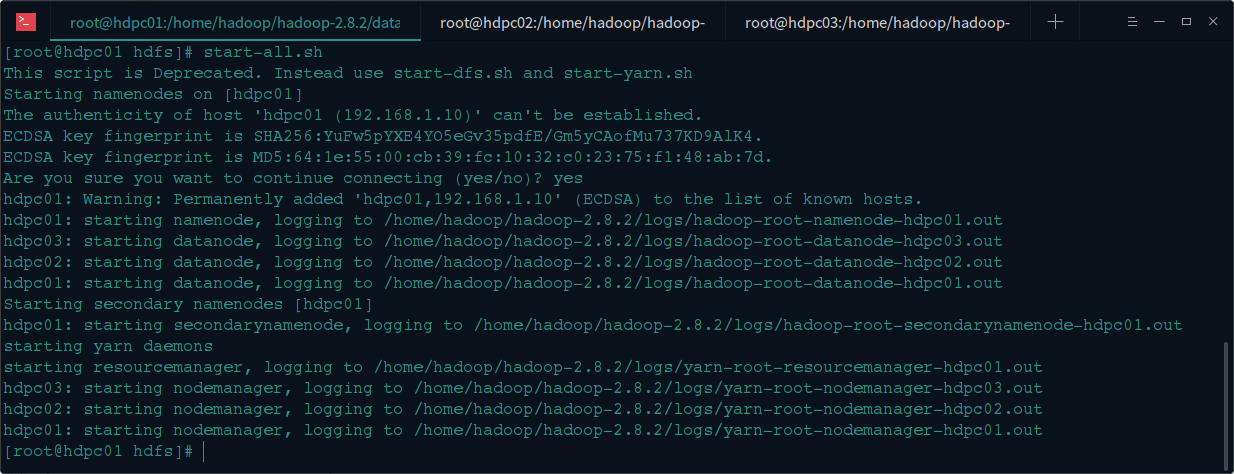

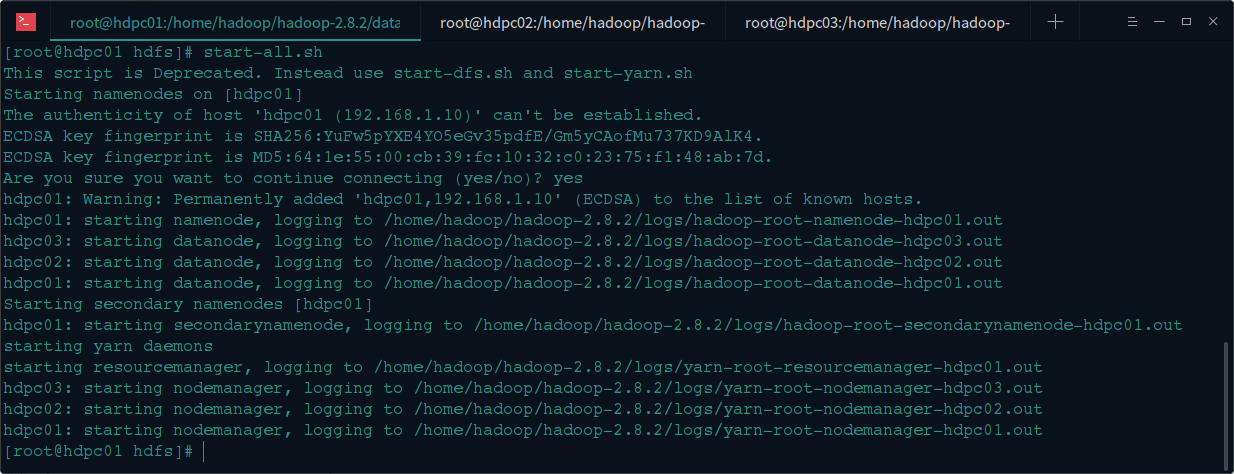

1.SSH连接Hadoop集群的master节点机器,启动hadoop集群

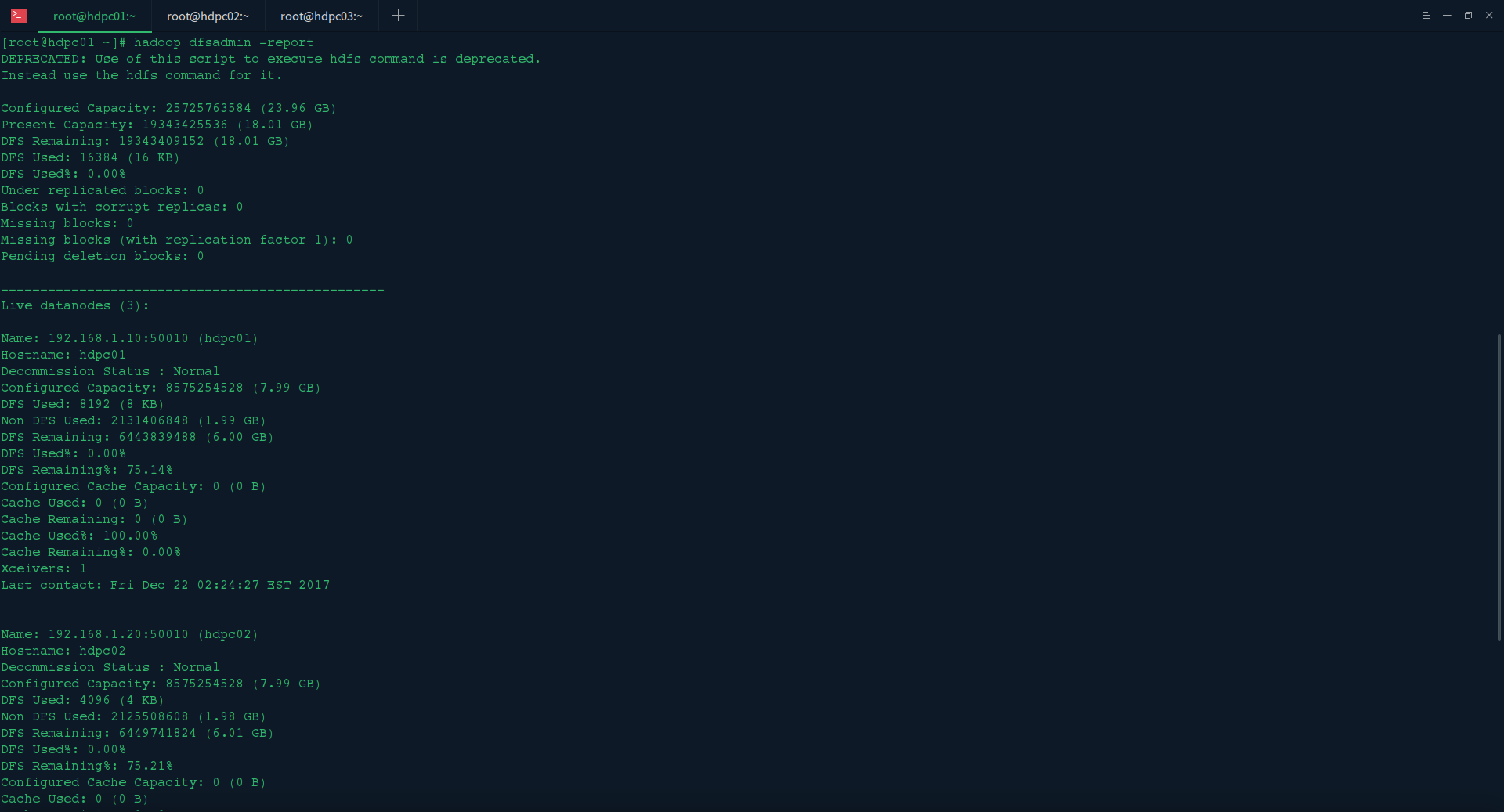

2.验证集群是否正常启动

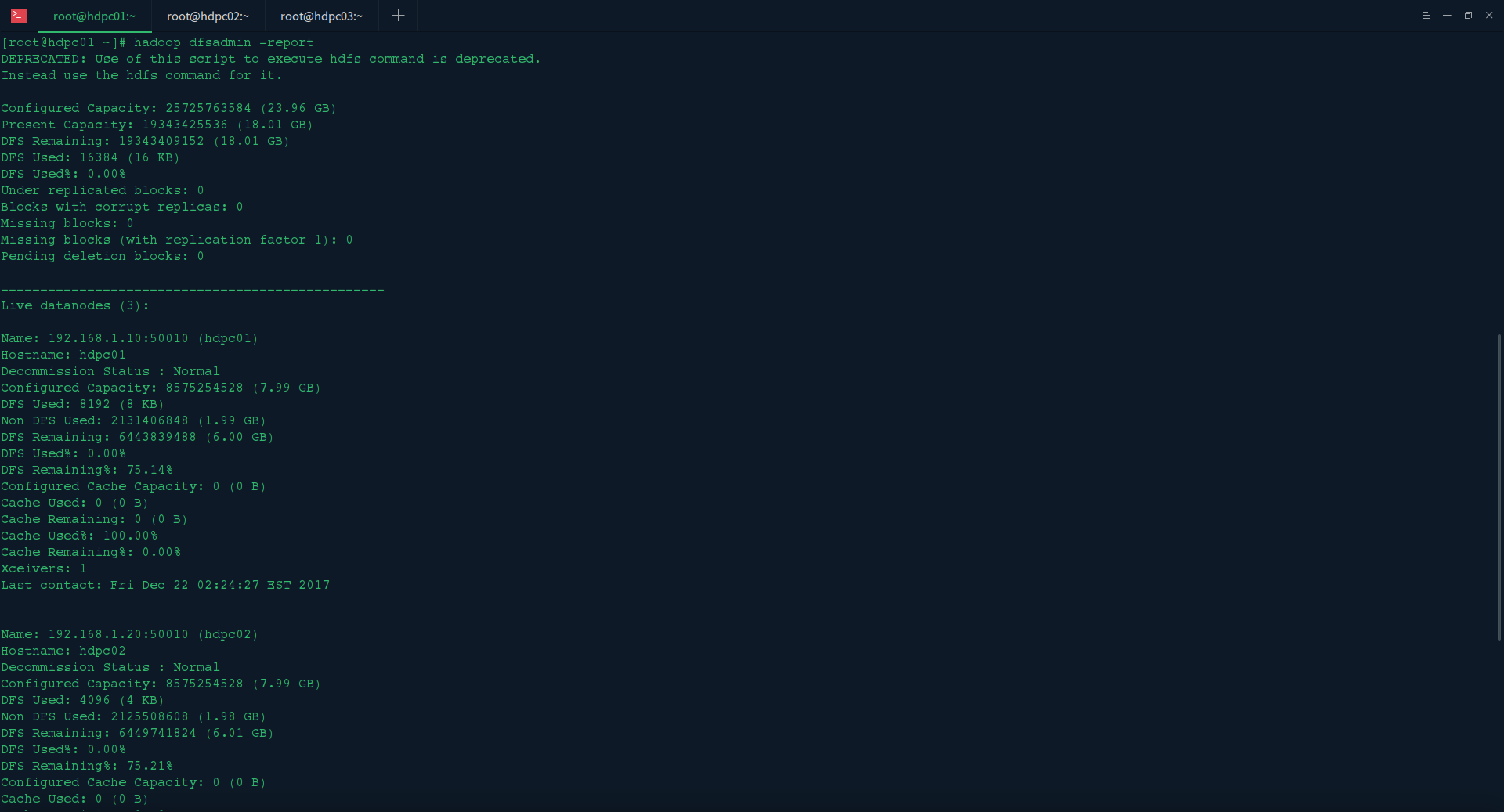

在master节点执行hadoop dfsadmin -report验证

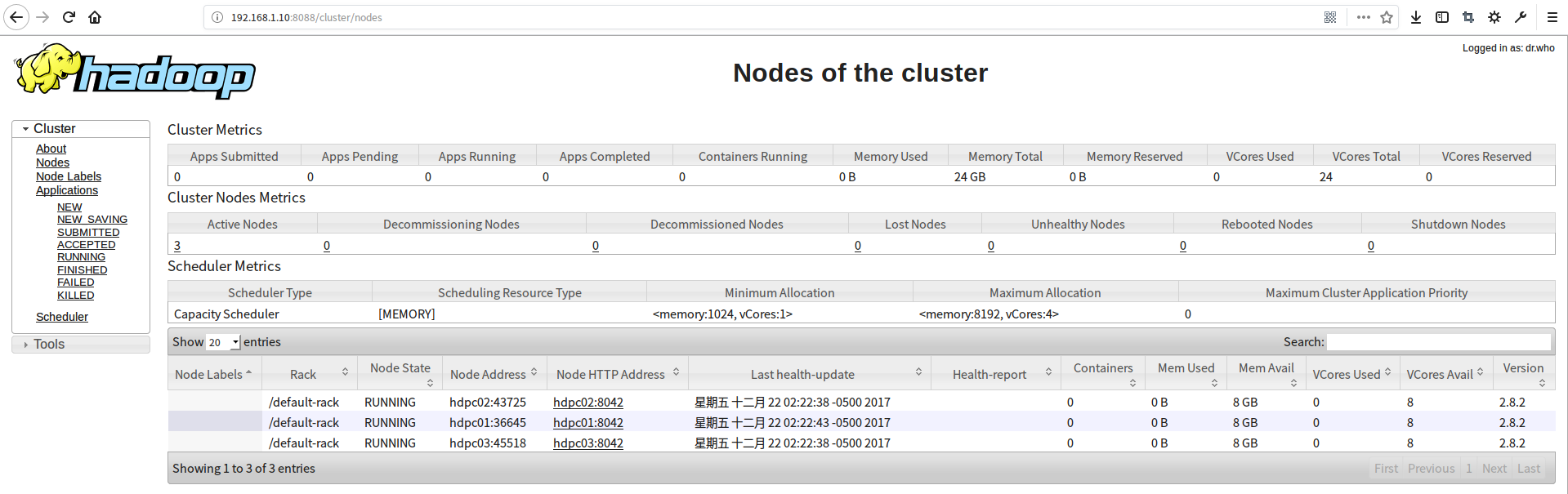

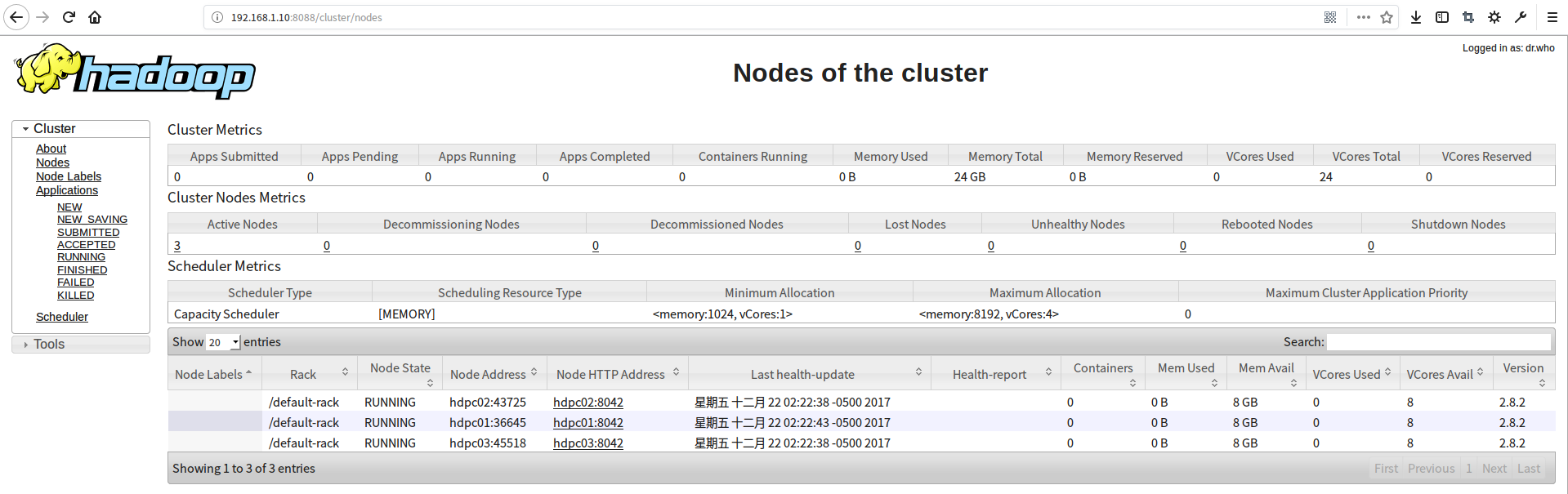

打开yarn的web查看

hadoop集群搭建可参考《hadoop(04)、Hadoop 集群模式搭建实践 》

四、创建配置Map/Reduce Locations

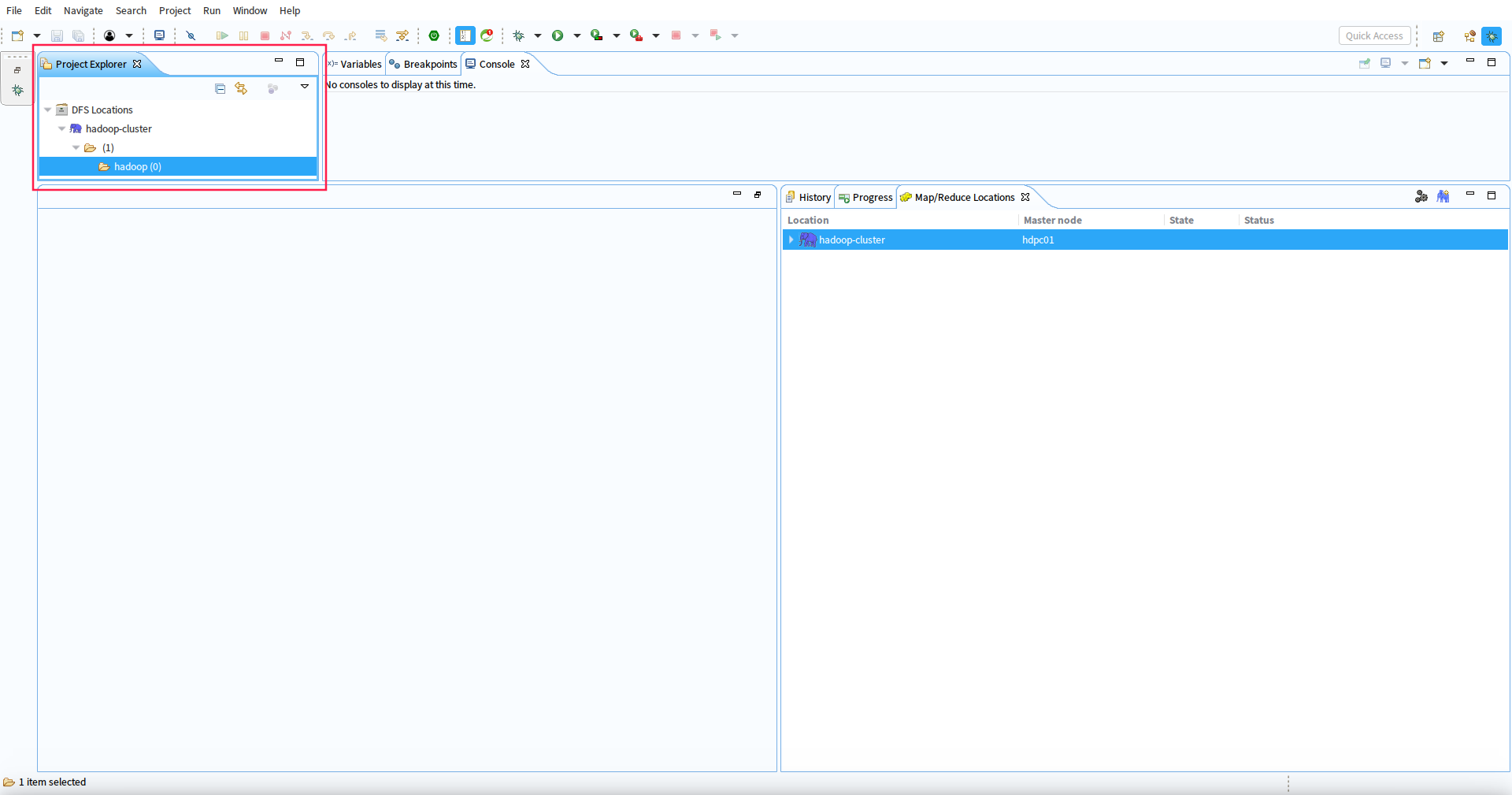

1. 打开eclispe到Map/Reduce Locations视图窗口

2.点击蓝色小大象按钮

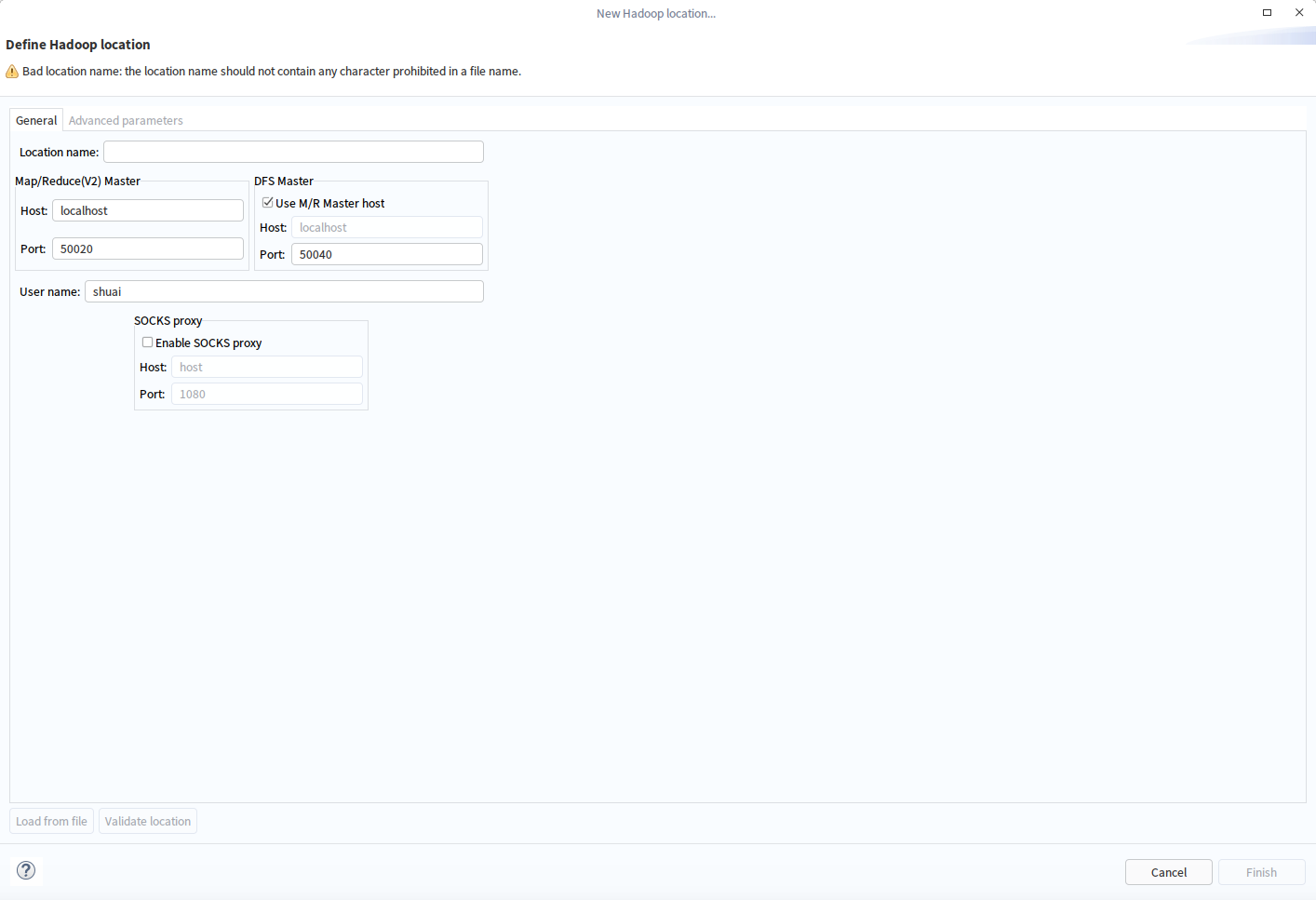

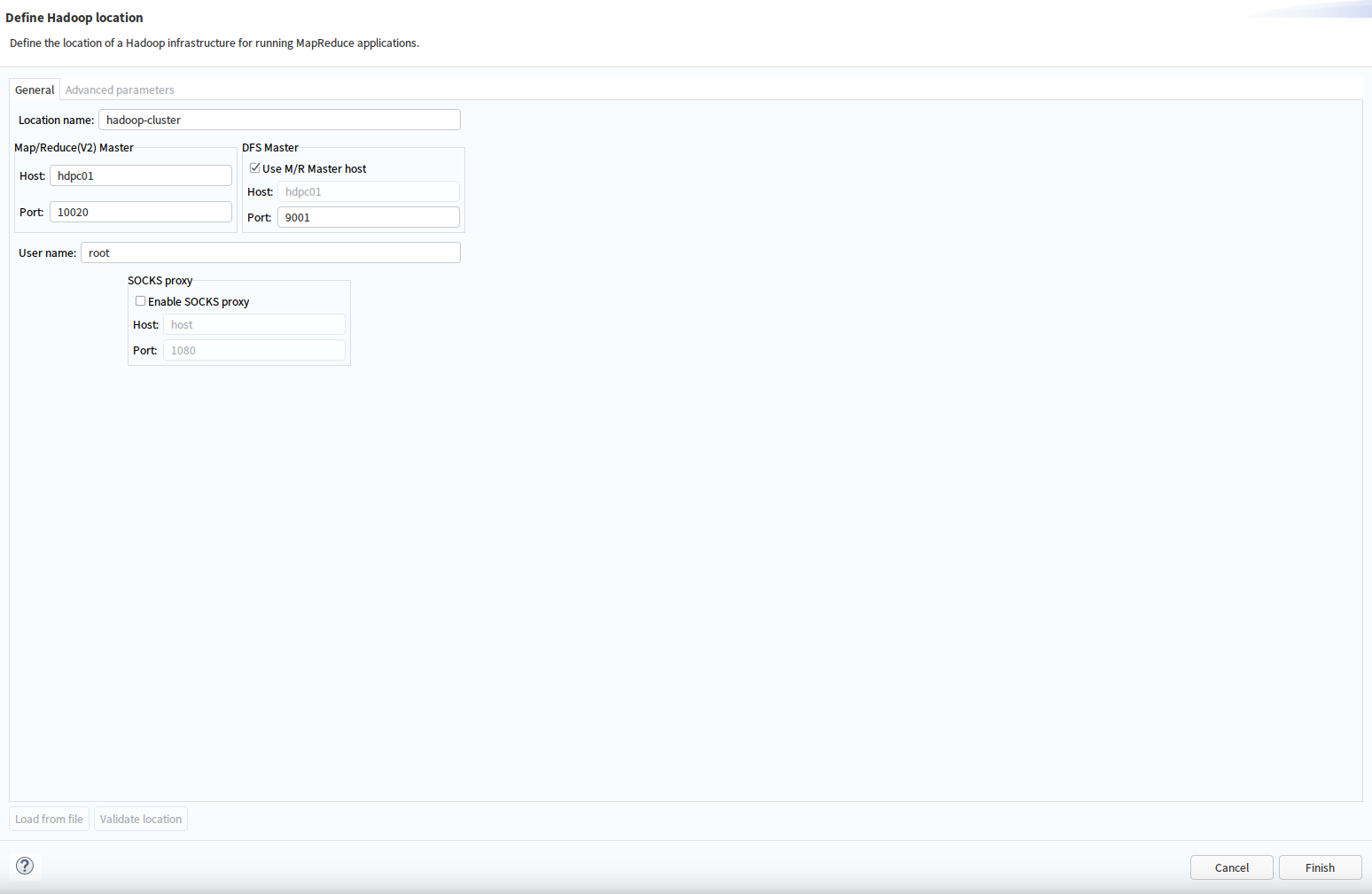

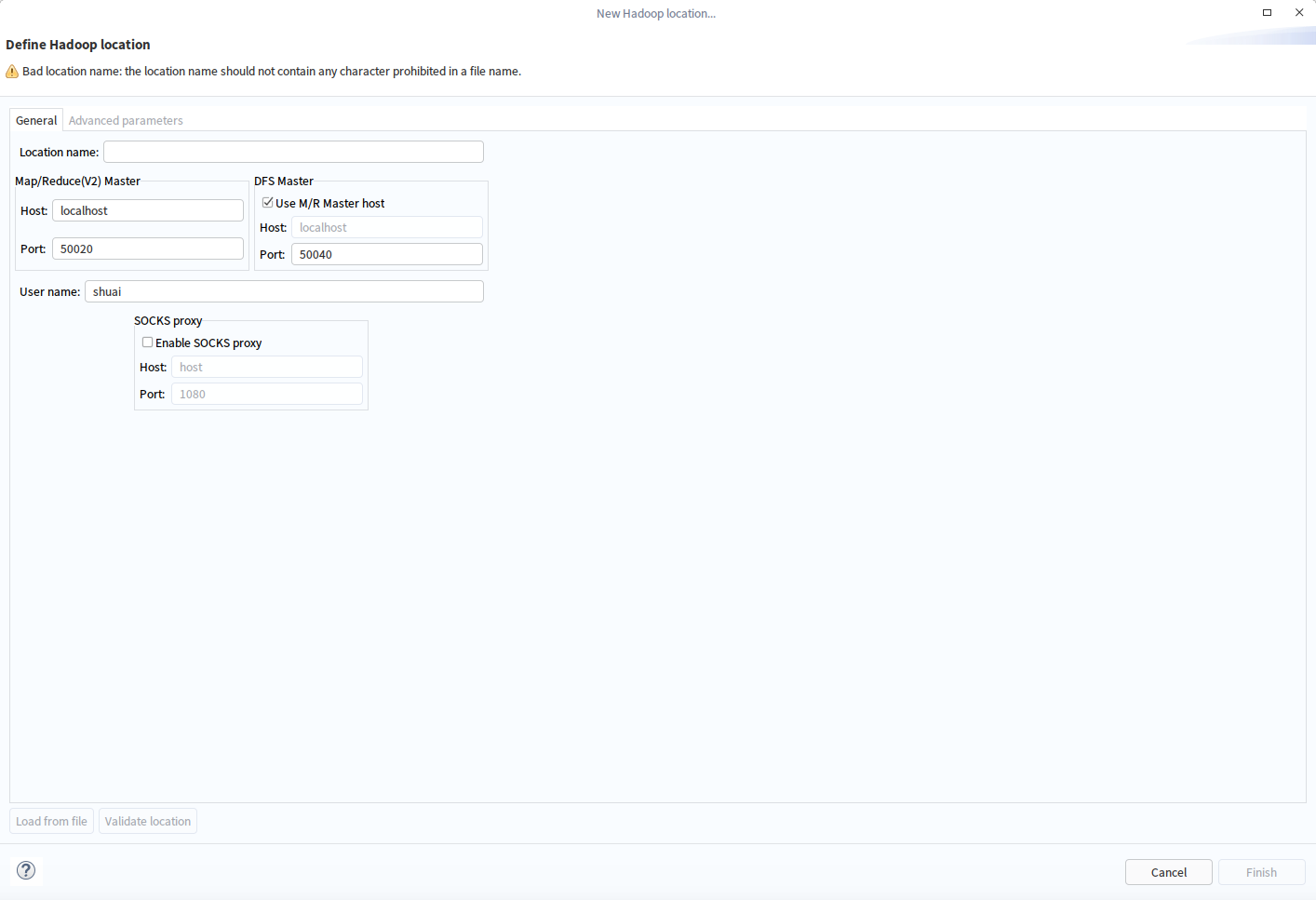

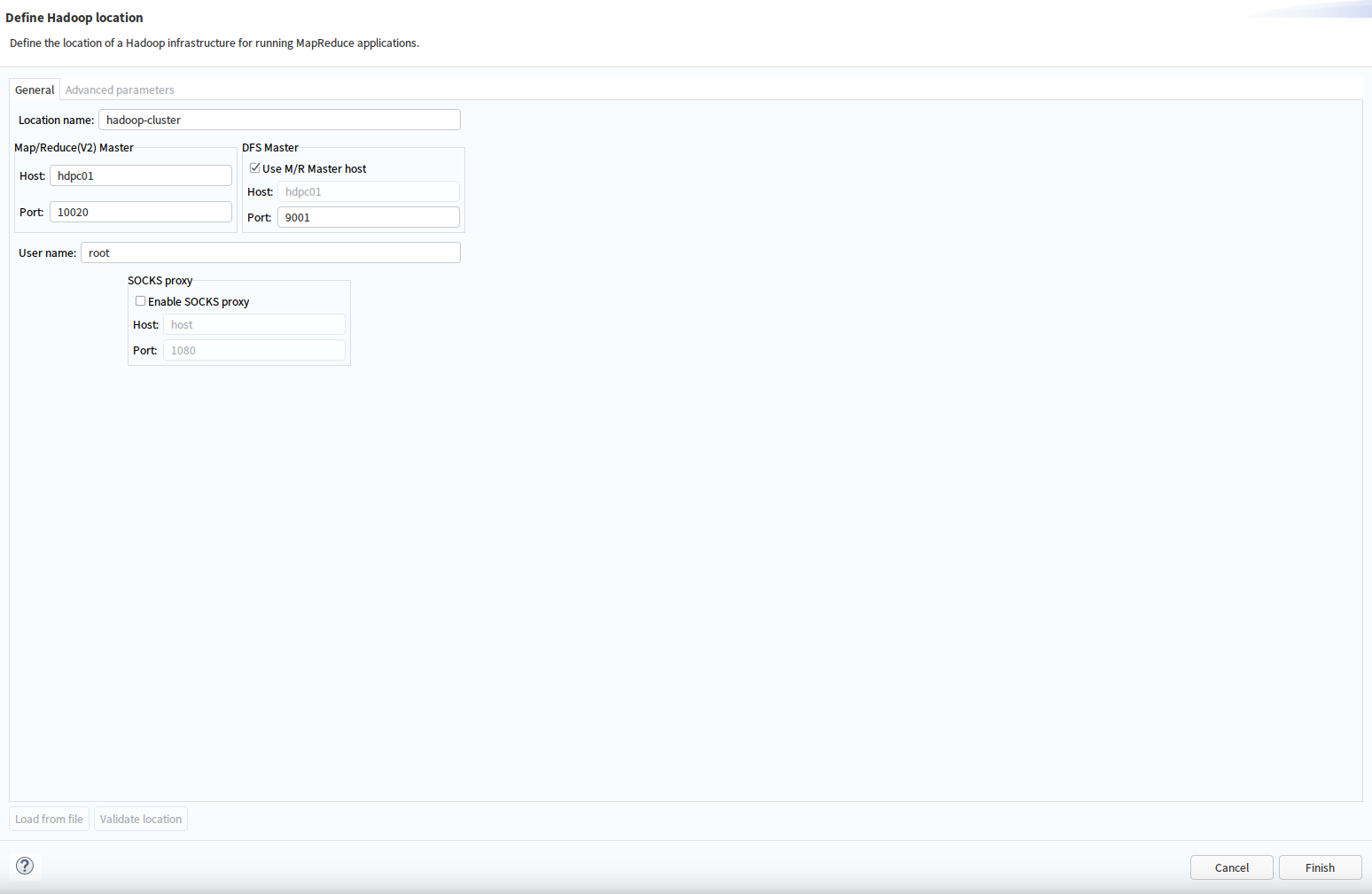

3.配置Map/Reduce Locations信息

注意填写参数:

Lacation Name:为该位置命名

MapReduce Master:与$HADOOP_DIRCONF/mapred-site.xml配置保持一致;

HDFS Master:与$HADOOP_DIRCONF/core-site.xml配置保持一致

User Name:登录hadoop用户名,可以填写其他的

4.点击完成即可

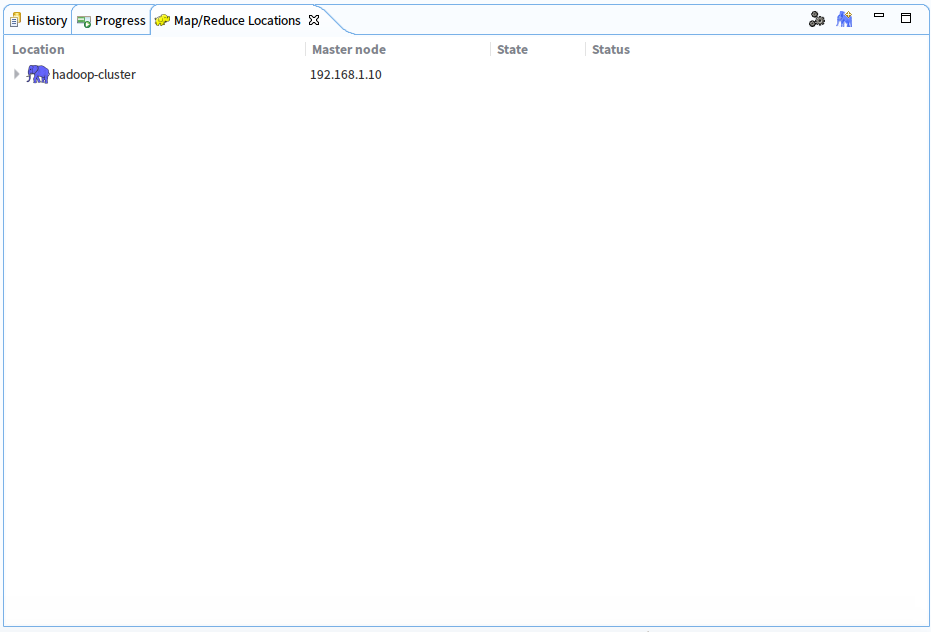

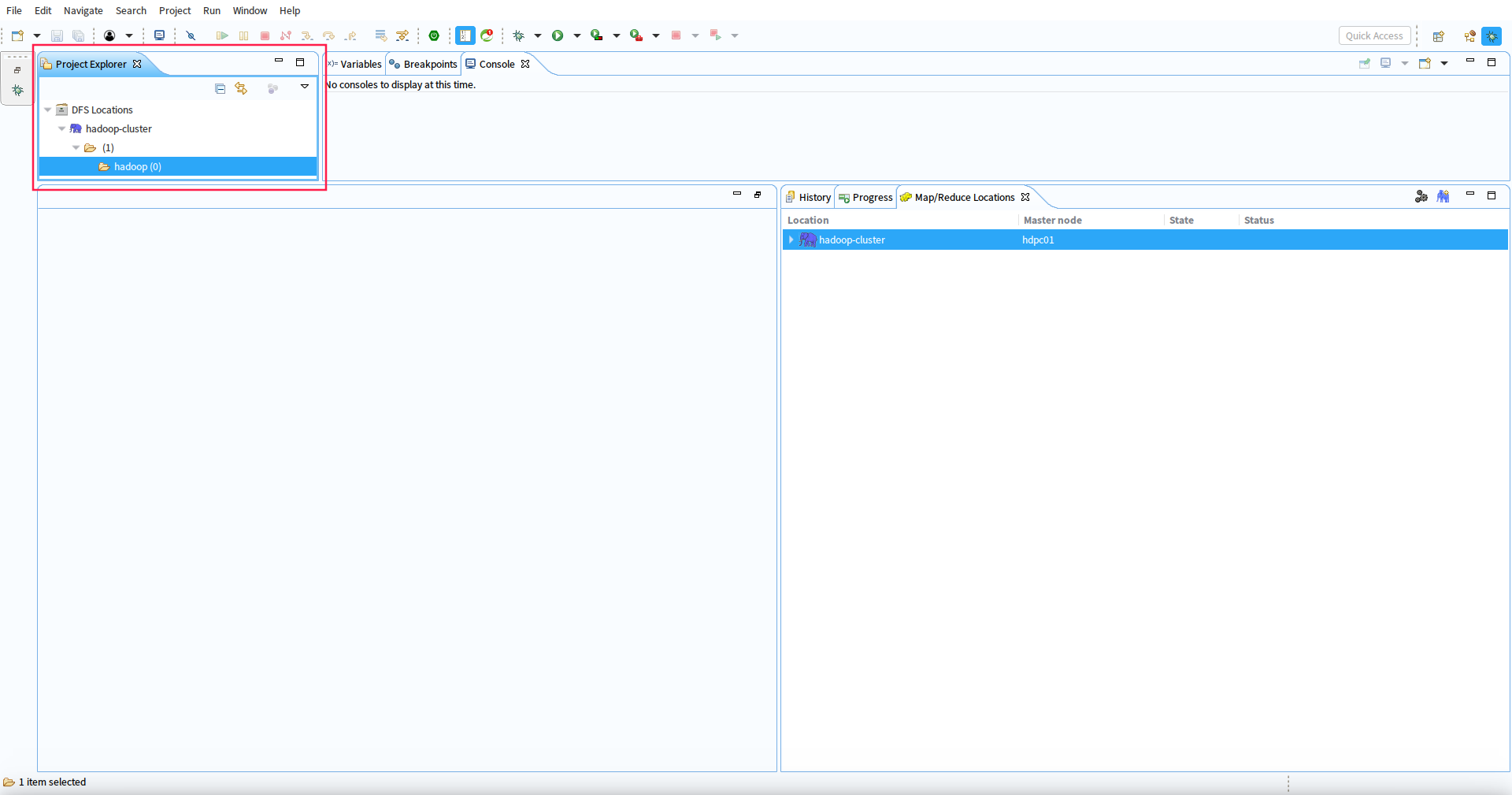

5.验证配置,点击DFS Locations

五、总结

本文主要实践了eclispe安装hadoop的插件,和在eclispe下使用hadoop插件连接远程hadoop集群的

操作,后面我们将使用改开发环境开发hadoop的作业任务。